随着生成式 AI 技术在各行业落地,越来越多的企业将目光投向了支持多种大模型即开即用的平台 —— Amazon Bedrock。然而,许多用户在初次接触时,会被其定价结构复杂、多模型定价差异大等问题困扰。本文将带你深入了解 AWS Bedrock 的计费模式、模型价格对比、成本优化策略,并结合企业真实使用场景,帮助你以更少预算实现更大价值。

什么是 AWS Bedrock?

Amazon Bedrock 是 AWS 推出的生成式 AI 模型即服务平台,提供来自多个顶尖 AI 实验室的基础大语言模型(Foundation Models),包括:

- Anthropic Claude

- Meta Llama 3

- Mistral

- AI21 Jurassic

- Cohere Command

- Amazon Titan

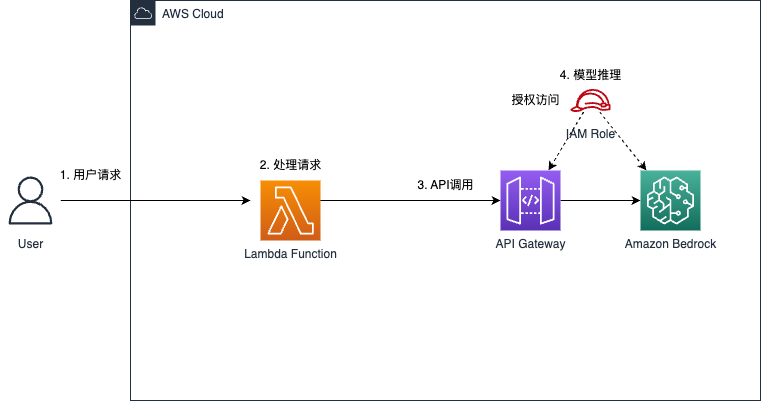

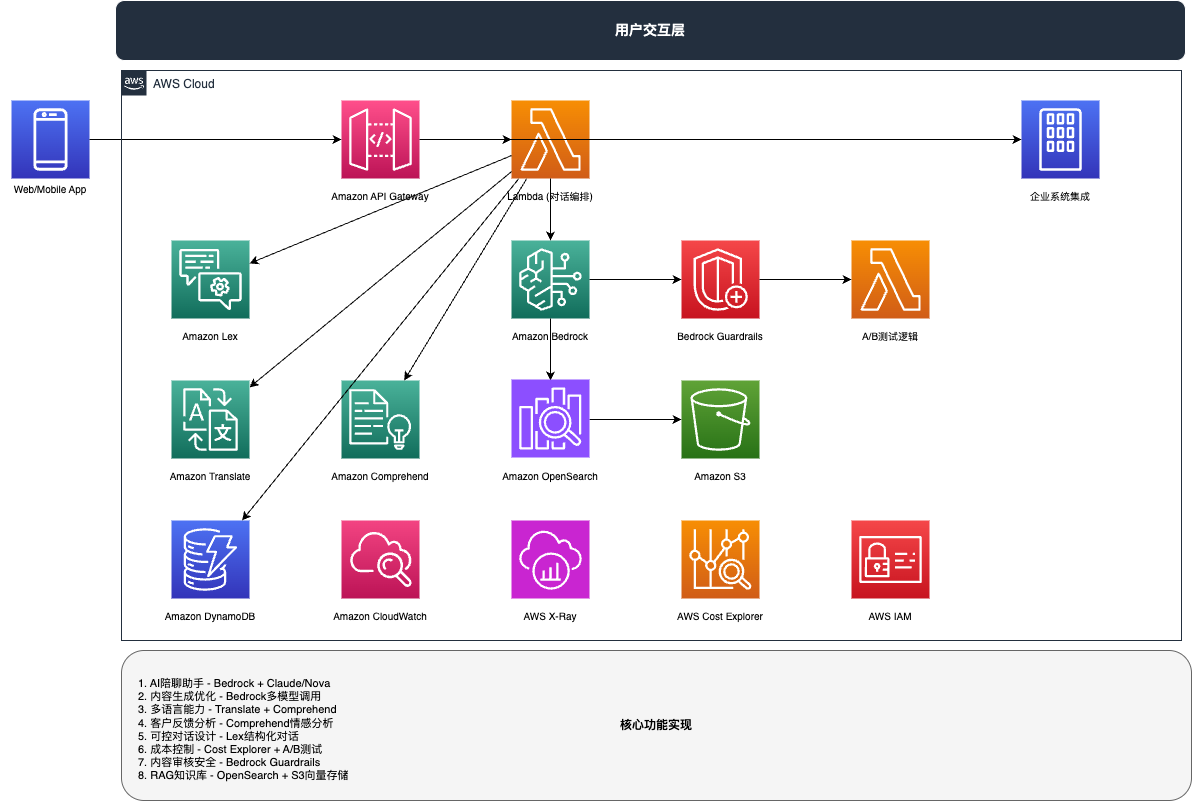

用户无需部署或管理底层 GPU 资源,便可直接通过 API 调用这些模型,实现文本生成、语义搜索、问答系统、代码生成等功能。其核心优势在于:高度灵活的模型选择 + 与 AWS 原生服务的深度集成。

AWS Bedrock 的计费模式详解

Bedrock 的定价主要由以下三部分构成:

1.模型调用费用(按 token 收费)

每个模型按输入 Token 和输出 Token 分别计价,价格因模型而异。

2.模型推理方式

- 实时推理(On-Demand):适用于低延迟、交互式场景。

- 批量推理(Batch):适合处理大规模任务,价格相对较低。

3.自定义模型与知识库(Knowledge Bases)

若启用 Retrieval Augmented Generation(RAG)功能,使用 Amazon S3 + Bedrock 的知识库能力,也会产生额外费用,如向量存储、索引构建、每次查询等。

不同模型,不同价格:如何选择?

| 模型 | 输入 Token | 输出 Token | 说明 |

| Claude 3 Sonnet | $0.003 / 1K | $0.015 / 1K | 智能均衡,适合对话系统 |

| Claude 3 Opus | $0.015 / 1K | $0.075 / 1K | 超强性能,成本较高 |

| Meta Llama 3 70B | $0.002 / 1K | $0.0028 / 1K | 开源大模型,性价比高 |

| Mistral 7B | $0.00045 / 1K | $0.0007 / 1K | 极低成本,适合入门 |

选择建议:

- 如果你追求最高性能与准确率,Claude 3 Opus 是首选,但注意其高成本。

- 对于中大型企业,Claude 3 Sonnet 适合绝大多数通用场景。

- 如果项目对预算敏感,Llama 3 与 Mistral 是高性价比之选。

Bedrock 的部署优势与企业集成能力

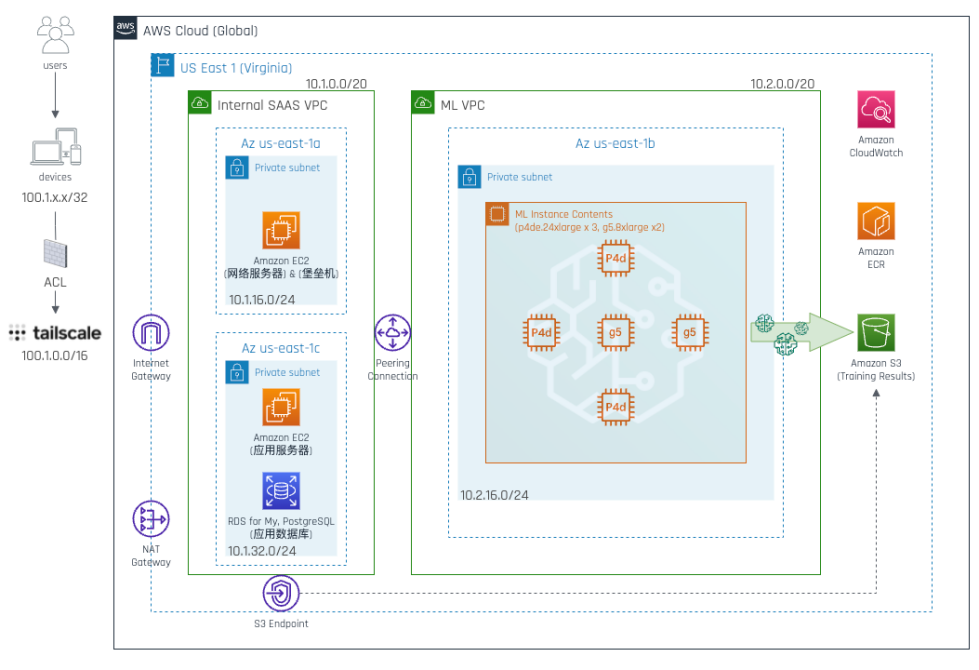

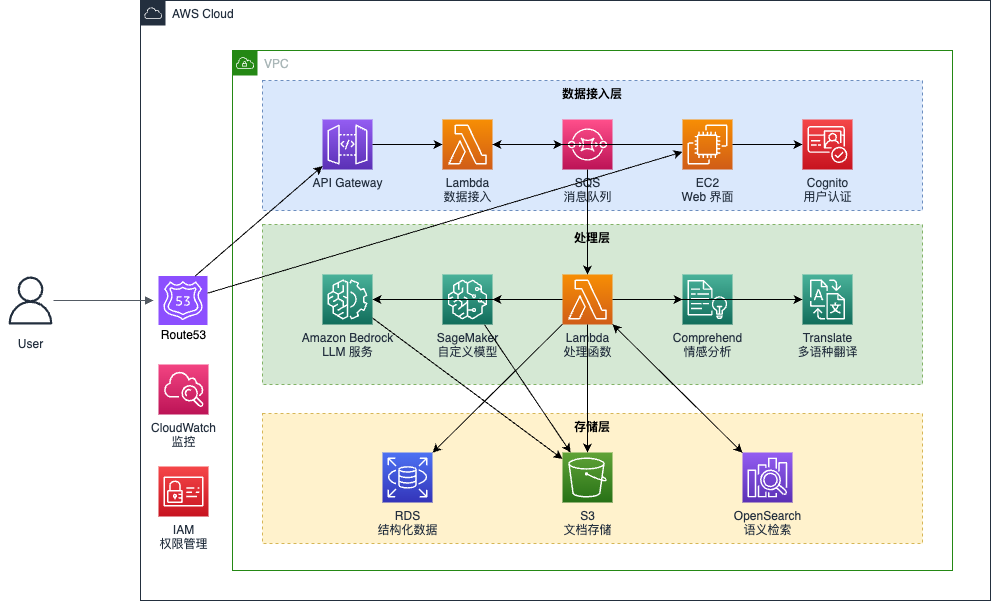

在生成式 AI 应用从探索走向大规模落地的过程中,部署效率与系统集成能力变得尤为关键。AWS Bedrock 提供了无需管理底层基础设施的 Serverless 部署方式,企业可以专注于模型调用与业务逻辑开发,极大减少了运维复杂性与上线周期。

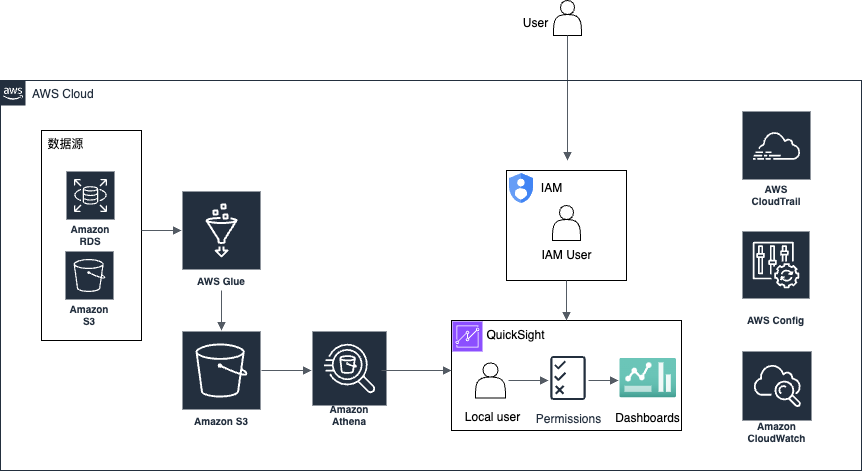

Bedrock 还原生集成了 AWS IAM、CloudTrail、KMS 等服务,帮助企业在调用模型时保障数据访问安全与合规性。例如,在金融与医疗行业中,客户可以通过 IAM 精细化控制哪些用户可以调用模型、处理哪些类型的数据,并通过日志审计满足监管要求。

此外,Bedrock 支持与企业现有系统对接:

- 可与 Amazon S3 结合构建私有知识库

- 搭配 Amazon API Gateway 实现对外 API 服务

- 与 Step Functions、Lambda 配合形成工作流自动化

这些能力不仅加快了应用开发周期,也降低了企业试错成本。对比自行部署大模型或调用开放平台,Bedrock 的集成性和稳定性对企业更具吸引力。

计费陷阱与优化建议

虽然 Bedrock 的使用体验优秀,但也容易产生“看似便宜、实际超支”的情况。以下是一些常见误区与优化建议:

误区 1:忽视输入输出 Token 的比例

某些模型(如 Claude 3 Opus)在输出 Token 计费高达 $0.075 / 1K,如果你的任务是生成长文本,成本会迅速上升。

建议:评估任务实际 Token 用量,设置输出长度上限。

误区 2:使用错误的模型类型

很多用户一开始就使用 Opus 处理简单任务,导致成本远超预期。

建议:先用 Sonnet 或 Mistral 验证任务效果,再考虑是否升级模型。

误区 3:忽视批量推理(Batch)的优势

对于非实时场景(如周报生成、合同摘要),使用批量推理可显著降本。

使用场景案例:从原型验证到企业生产

Bedrock 在不同行业中均有落地场景:

- 金融行业:结合私有知识库,实现合规问答系统,支持多模型自动轮询比对答案。

- 电商平台:通过批量推理优化商品描述生成,提高 SEO 转化率。

- 教育行业:构建智能写作助手,实现自动评分、内容生成。

这些案例都体现了 Bedrock 不仅适用于探索型项目,更可用于企业级生产环境。

提供本地化支持与定制方案

作为 AWS 官方认证代理商,「在云上」可为企业提供一站式 Bedrock 解决方案服务:

- 协助企业评估模型调用成本与使用策略,制定合理预算

- 提供专属测试账号,帮助团队快速上手 Bedrock 平台

- 配合 AWS 原厂资源,为客户申请试用额度、POC 支持

- 提供技术实施与知识库搭建服务,保障从部署到上线的全流程顺利推进

无论你是刚接触生成式 AI 的团队,还是准备规模化落地的企业,「在云上」都能提供本地化、可落地、可持续的支持。

AWS Bedrock 与其它 AI 平台的对比

AWS Bedrock 的优势不仅仅在于其模型丰富与灵活性,它与同类平台相比,在集成能力和成本控制方面也具有显著优势。许多企业选择 AWS 是因为其广泛的云服务和强大的计算能力支持。特别是与 Amazon SageMaker 结合,Bedrock 能够支持更复杂的定制化需求和跨平台的数据整合。

相比其它平台(如 OpenAI API),AWS Bedrock 的按需定价使得预算较紧的企业能灵活选择适合自己业务规模的模型,同时 AWS 的广泛云计算资源也为大规模企业提供了坚实的支持。

总结

AWS Bedrock 是一款功能强大、灵活性高的生成式 AI 服务平台,其按需计费模式为企业提供了极大的自由度。但想要用好 Bedrock,就必须深刻理解不同模型的定价机制、性能差异,并结合业务需求做出最优选择。

如果你正在考虑接入 Bedrock,不妨联系在云上团队,我们将帮助你从技术选型到成本优化,全面提升 AI 投入产出比。

如需了解更多关于 AWS Bedrock 的定价建议或申请企业试用方案,欢迎联系「在云上」市场团队,我们将为你提供定制化支持。